Muitos cientistas acreditam que problemas morais não são sistematizáveis

e que qualquer tentativa de dar senso de moralidade às máquinas

pode ser o caminho para criar os problemas que se está tentando evitar.

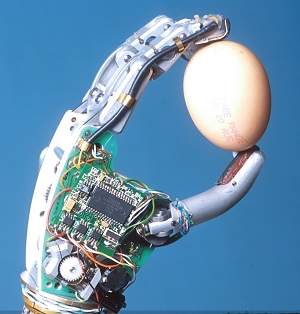

[Imagem: Kevin Warwick]

e que qualquer tentativa de dar senso de moralidade às máquinas

pode ser o caminho para criar os problemas que se está tentando evitar.

[Imagem: Kevin Warwick]

Máquinas que dominam o homem

Uma dupla de pesquisadores de Portugal e da Indonésia descreveu uma nova metodologia, baseada na tomada de decisão por lógica computacional que, segundo eles, poderá um dia dotar as máquinas - computadores e robôs - com um senso de moralidade.

Os autores de ficção científica sempre exploraram o tema das máquinas que tomam o controle da situação e exercem algum tipo de dominação sobre o homem. A Skynet, da série O Exterminador do Futuro, e o computador Hal 9000, de 2001: Uma Odisseia no Espaço são os exemplos mais lembrados de uma longa lista na qual as máquinas de Matrix parecem representar a distopia final de uma colaboração histórica - as máquinas que ajudam o homem - que eventualmente poderia se transformar em mais um caso de dominação.

Lógica prospectiva

Luís Moniz Pereira, da Universidade Nova de Lisboa, em Portugal e Ari Saptawijaya da Universidade da Indonésia, acreditam que esse futuro - se de fato a suspeita vier a se transformar em possibilidade, ou eventualmente em risco - poderá ser minimizado com a aplicação adequada de lógica computacional e de mais inteligência artificial.

"A moral já não pertence mais apenas ao reino dos filósofos. Recentemente, tem havido um crescente interesse em compreender a moral do ponto de vista científico", dizem os pesquisadores em seu artigo.

Eles analisaram um sistema conhecido como lógica prospectiva para começar a a programar a moralidade em um computador. De forma bastante simplificada, a lógica prospectiva permite que se modele um dilema moral e, em seguida, sejam determinados os resultados lógicos das possíveis decisões.

Ética das máquinas

A abordagem poderá, acreditam os pesquisadores, representar a emergência da ética das máquinas, permitindo desenvolver equipamentos completamente autônomos que poderão ser programados para fazer julgamentos com base nos fundamentos da moral humana.

"Equipar os agentes de software com a capacidade de tomar decisões morais é uma exigência indispensável. Isto é particularmente verdadeiro quando os agentes estão operando em domínios onde os dilemas morais ocorrem, por exemplo, no campo da saúde e da medicina," diz o artigo.

Os pesquisadores também apontam que a ética das máquinas poderá ajudar os psicólogos e cientistas da cognição a encontrar novas formas de compreender o raciocínio moral nas pessoas e, eventualmente, extrair os princípios morais de situações complexas que ajudem as pessoas a decidir o que é certo e o que é errado. Tal entendimento poderia então ajudar no desenvolvimento de sistemas educativos inteligentes para ensinar a moralidade às crianças, defendem eles.

Dilema do bonde

Para demonstrar sua abordagem, os pesquisadores criaram um programa para resolver o famoso "dilema do bonde", um exercício de pensamento ético apresentado pela filósofa britânica Philippa Foot na década de 1960.

O problema envolve um bonde fora de controle correndo por uma rota em cujos trilhos estão amarradas cinco pessoas. A pessoa que está fazendo o teste pode girar uma chave que enviará o bonde para uma rota diferente, em cujos trilhos está amarrada uma única pessoa. O dilema é: Deve-se ou não girar a chave?

O programa de lógica prospectiva pode considerar cada resultado possível com base em diferentes versões do problema e demonstrar logicamente as consequências das decisões tomadas em cada um dos casos. O próximo passo seria dotar cada resultado com um peso moral, de modo que o programa possa fazer o melhor juízo e decidir se deve ou não girar a chave. Ou seja, a consideração moral de cada situação é substituída por um "julgamento a-priori, a cargo do programador.

Criando o problema

A dupla de pesquisadores não está sozinha nessa busca de sistematização da moral. Mas existem muitos mais cientistas do outro lado, do lado dos que acreditam que problemas morais não são sistematizáveis e que qualquer tentativa de dar senso de moralidade às máquinas pode ser o caminho para criar os problemas que se está tentando evitar.

A atribuição de qualquer "programa de lógica moral" a um equipamento poderá dar a falsa sensação de que essas máquinas - sejam computadores ou robôs - tomarão sempre a melhor decisão, o que nunca será um pressuposto válido.

Além do fato de que essas máquinas serão programadas por humanos - que serão, em última instância, os responsáveis pelas decisões morais tomadas - haverá sempre o risco dos problemas de software, os conhecidos bugs. Sem contar o fato de que é impossível inserir no programa todos os tipos de dilemas morais com que se poderá se defrontar uma máquina no dia-a-dia.

Fonte: Site Inovação Tecnológica.

Nenhum comentário:

Postar um comentário